Ce que l’IA ne peut pas faire à notre place

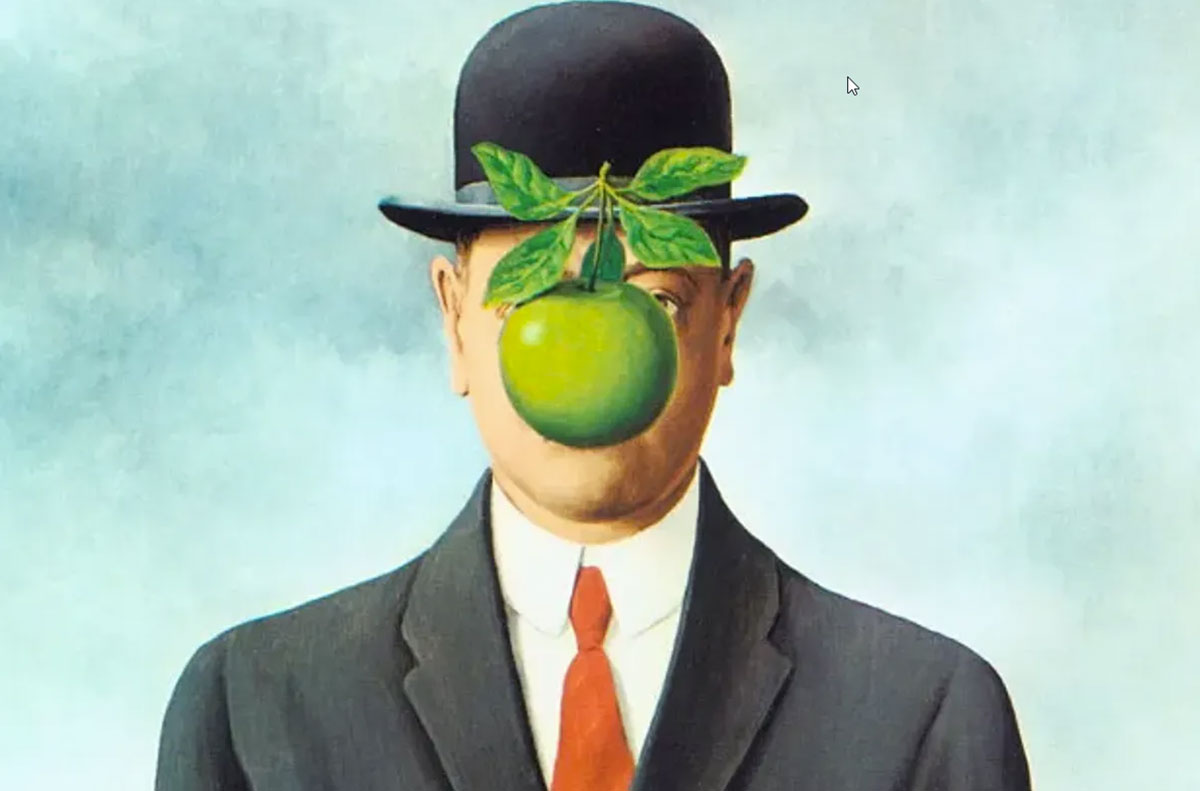

Les intelligences artificielles savent répondre, synthétiser, structurer, reformuler. Elles donnent parfois l’impression de penser. Pourtant, cette impression repose sur une confusion majeure : penser n’est pas calculer.

Comprendre cette différence est décisif pour les étudiants. Non seulement pour éviter un contresens philosophique, mais aussi pour apprendre à utiliser l’IA comme un outil intellectuel, sans lui déléguer ce qui fait précisément la valeur du travail universitaire : la conceptualisation.

Relier des concepts n’est pas conceptualiser

Une intelligence artificielle est très performante pour relier des concepts. Elle identifie des régularités, rapproche des notions, établit des correspondances. Mais conceptualiser, ce n’est pas relier : c’est produire un concept, c’est-à-dire instituer une manière déterminée de saisir le réel.

Chez Immanuel Kant, un concept n’est ni un simple mot ni une définition. C’est une condition de possibilité de l’expérience : sans concept, il n’y a pas d’objet pensé, seulement un flux indéterminé de sensations.

L’intelligence artificielle, elle, n’institue rien. Elle applique des structures conceptuelles déjà produites par des humains. Elle reconnaît des formes, mais ne décide jamais ce qui mérite d’être pensé ni comment le réel doit être découpé.

Exemple : si tu demandes à une IA d’expliquer la notion de liberté chez Sartre, elle le fera correctement. Mais elle ne peut pas décider en quoi cette notion est problématique aujourd’hui, ni pourquoi elle devrait être centrale dans ton devoir plutôt qu’une autre.

Penser suppose un point de vue situé

Penser, ce n’est pas produire une réponse correcte. C’est adopter un point de vue, situé historiquement, socialement et intellectuellement.

Comme le montre Gilles Deleuze, un concept n’est jamais neutre : il est une création forgée pour répondre à un problème. Or, il n’y a pas de problème sans sujet concerné par ce problème.

L’IA n’a pas de point de vue. Elle ne parle jamais depuis une situation. Elle produit des discours sans position, sans engagement, sans exposition.

Dans une dissertation, le cœur du travail n’est pas la restitution du cours, mais la construction d’une problématique. Une IA peut reformuler une problématique existante, mais elle ne peut pas décider laquelle est intellectuellement pertinente pour toi.

Une IA ne pourrait-elle pas conceptualiser un jour ?

On objecte souvent que l’IA ne conceptualise pas encore, mais qu’elle le pourra un jour, à mesure que la complexité ou la puissance de calcul augmente.

Cette objection confond deux choses : la complexité des opérations et le statut du sujet. Or le problème n’est pas technique, il est ontologique.

Comme l’a montré John Searle, manipuler correctement des symboles ne suffit pas à comprendre ce qu’ils signifient. La conceptualisation suppose une intention, un « à propos de », que la machine ne possède pas.

Augmenter la puissance de calcul ne constitue pas un sujet. Cela perfectionne une simulation.

Pas d’erreur possible, donc pas de pensée

On dit souvent que l’IA se trompe. En réalité, elle ne se trompe pas : elle ajuste. Se tromper suppose d’avoir voulu dire quelque chose et de pouvoir reconnaître que ce que l’on a dit était faux.

La pensée humaine est exposée au vrai et au faux. L’IA n’est exposée qu’au plausible et à l’improbable. Elle ne revient jamais sur une position, car elle n’en a jamais défendu.

Exemple : quand vous critiquez un raisonnement, cette critique s’adresse à un auteur responsable. Une IA ne peut ni assumer une erreur ni en tirer une réorientation intellectuelle.

Outil ou substitution : une frontière à ne pas franchir

La tradition philosophique n’a jamais rejeté les outils intellectuels. Ce qu’elle refuse, c’est la substitution du jugement.

Ce que l’IA peut faire : clarifier un cours, reformuler une idée comprise, proposer des exemples, aider à structurer un texte déjà pensé.

Ce qu’elle ne doit pas faire : formuler la problématique à ta place, décider du plan, produire la thèse centrale du devoir.

Déjà chez Aristote, penser n’est pas produire un résultat, mais exercer une activité : la pensée est une praxis, non un simple produit.

Un étudiant est devant sa dissertation. Il comprend le sujet, mais hésite sur la problématique. Deux options s’offrent à lui : demander à une IA « un bon plan », ou rester avec l’inconfort de la question.

Ce moment d’hésitation est précisément le lieu de la pensée. Le court-circuiter, c’est produire un texte. Le traverser, c’est commencer à conceptualiser.

Un critère simple pour s’auto-évaluer

Si votre nom peut être retiré du devoir sans que rien ne change, alors vous n’avez pas encore vraiment pensé.

Comme l’a montré Hannah Arendt, penser, ce n’est pas appliquer mécaniquement des règles : c’est assumer la responsabilité de juger.

Conclusion

Une intelligence artificielle peut relier des concepts, prévoir des tendances, produire des textes cohérents. Mais elle ne peut ni conceptualiser, ni donner un sens, ni répondre de ce qu’elle produit.

Penser n’est pas calculer.

Et pour un étudiant, comprendre cette différence, c’est déjà entrer dans la philosophie.

Dans le prochain article, nous verrons pourquoi produire du texte n’est pas écrire, et pourquoi l’IA, même très performante, ne sait pas écrire au sens fort.